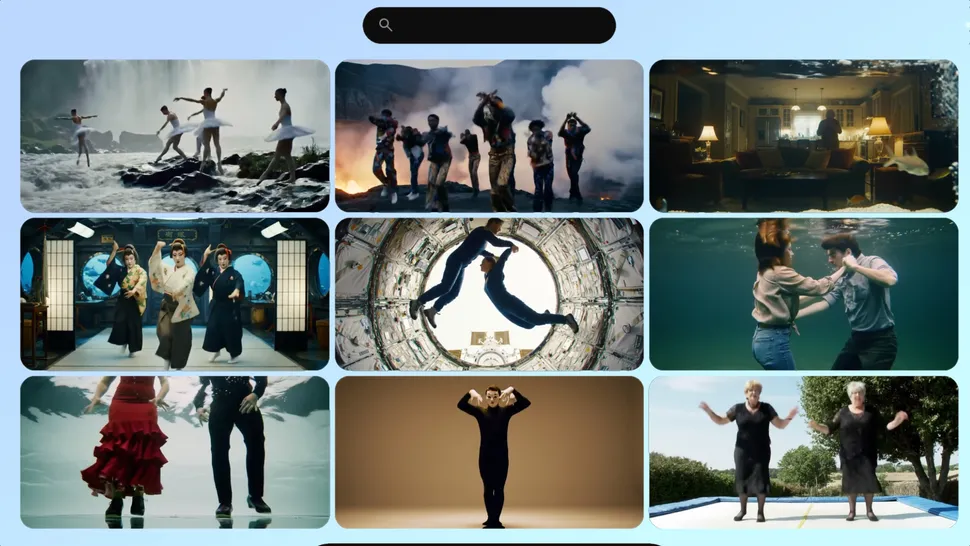

شاید در روزهای اخیر تصاویر عجیب و غریب از افراد مشهور و سرشناس در موقعیتهای عجیب و نامتعارف، دیده باشید. از عکسهای خنده دار افرادی با چهره ایلان ماسک، تا بازی بروس لی در فیلم ماتریکس! تعجب نکنید. این عکسها حاصل استفاده از فناوری یادگیری عمیق هستند. یادگیری عمیق حالا برای جا بهجا کردن چهره افراد بهطور کاملاً باور پذیر و واقعی استفاده میشود و صاحب نام اختصاصی خود یعنی دیپ فیک یا جعل عمیق را شده است. تکنیک دیپ فیک افراد زیادی را نگران کرده چرا که به شکل غیرقابل تصوری از آن برای جعل فیلمهای مستهجن استفاده میشود! و به نظر میرسد فعلاً اوضاع کاملاً از کنترل خارج شده!

احتمالاً بهزودی این فناوری آنقدر گسترده خواهد شد که دیگر همه به آن دسترسی پیدا خواهند کرد. درست مثل فتوشاپ. بهزودی هر کسی میتواند چهره هر کسی را که میخواهد بر روی افراد دیگر بیندازد و فیلم و کلیپ جعل کند.

تا فعلاً، تعداد زیادی از بازیگرها، ورزشکاران، خوانندهها و افراد سرشناس دیگر قربانی فناوری دیپ فیک شدهاند و شمار قربانیان بهسرعت در حال افزایش است! هر چند بیشتر قربانیان سلاح درک عمیق را زنان تشکیل میدهند.

به غیر از ساخت فیلم و تصاویر غیراخلاقی، از این فناوری برای باج گیری هم استفاده میشود. این فناوری بهراحتی میتواند برای از بین بردن روابط خانوادگی و باج گیری استفاده شود. مشخص است که اگر بهزودی راهی برای تشخیص ویدیوهای اصیل از غیر اصیل پیدا نشود، جامعه دچار بحرانی بزرگ خواهد شد که فقط با شک و تردید به همه چیز باید نگاه کرد. تصور کنید چه اتفاقی میافتد اگر تمام تصاویر دوربینهای امنیتی و حتی گفت و گو های تلفنی را بتوان جعل کرد! در واقع از نظر فنی جعل کردن صدا سادهتر از جعل کردن ویدیو و تصاویر است. بنابراین اگر امکان جعل کردن تصویر وجود دارد، قطعا جعل کردن صدا هم ممکن است.

با پیشرفت پر شتاب یادگیری عمیق، در آینده نزدیک ساخت ویدیو و صدا از هیچ هم امکان پذیر خواهد شد. ویدیوهایی کاملاً طبیعی که تشخیص واقعی یا غیرواقعی بودن آنها بسیار مشکل خواهد بود.

محققین در تلاشاند که هر چه سریعتر راهی پیدا کنند که حداقل چهرههای شناخته شده و معتبر را از گزند دیپ فیک به دور نگه دارند. پیشرفتهایی هم در این مسیر حاصل شده و محققین توانستهاند روشی مورد قبول دادگاه برای مشخص کردن جعلی بودن ویدیوها پیدا کنند. ولی این بهتنهایی کافی نیست و باید راهی برای جلوگیری از استفاده نادرست از یادگیری عمیق پیدا کرد تا امنیت همه مردم تأمین شود

منبع: