شرکت اپل امروز از تغییرات جدیدی در آیفون، آیپد و مک برای مراقبت هر چه بیشتر از کودکان خبر داد که شامل امکان امنیتی جدید برای اپلیکیشن Messages، پیشرفته تر شدن محتوای سوء استفاده جنسی از کودکان (CSAM) در آیکلود و به روزرسانی اطلاعات سیری و جستجو است.

به گفته شرکت اپل این طرح جدید بلند پروازانه است اما مراقبت از کودکان مسئولیت مهمی است. به این ترتیب به گفته اپل این تلاشها به مرور زمان رشد و گسترش پیدا میکنند.

Messages

اولین اعلامیه امروز مربوط به اضافه شدن یک قابلیت امنیتی جدید در اپلیکیشن Messages است. اپل توضیح داده که وقتی کودکی که در طرح iCloud Family است عکسهای مربوط به سوء استفاده جنسی را دریافت یا ارسال میکند، یک پیام هشدار خواهد دید.

طبق توضیحات اپل وقتی کودکی تصاویر جنسی صریح دریافت میکند، این تصاویر تار شده و اپلیکیشن Messages یک هشدار نمایش میدهد با این متن که ممکن است این تصویر دارای حساسیتهای خاصی باشد. اگر کودک روی View photo ضربه بزند، پیامی مشاهده میکند با این توضیحات که چرا این عکس حساس در نظر گرفته شده است.

در این متن توضیح داده شده که اگر کودک تصمیم به دیدن عکس بگیرد، پدر یا مادر او در iCloud Family یک اعلان دریافت میکنند حاوی لینکی برای دریافت راهنمایی و کمک بیشتر.

بعلاوه، اگر کودک بخواهد عکسی حاوی محتوای جنسی نامناسب ارسال کند، باز هم یک هشدار مشابه خواهد دید. به گفته اپل قبل از ارسال عکس برای کودک هشدار ارسال میشود و اگر سن او کمتر از 13 سال باشد، در صورت ارسال چنین پیامهایی، برای والدین هم یک پیام هشدار ارسال میشود.

اپل توضیح داده که Messages از یادگیری ماشینی برای تحلیل تصاویر پیوست و شناسایی محتوای جنسی استفاده میکند. iMessage همچنان رمزنگاری سرتاسری خواهد داشت و اپل به هیچ پیامی دسترسی ندارد. این قابلیت هم اختیاری خواهد بود.

به گفته اپل قرار است امسال با آپدیت iOS 15، iPadOS 15 و macOS Monterey این قابلیت برای اکانتهایی که به صورت خانوادگی درای کلود تنظیم شده اند فعال شود. کاربران آمریکایی اولین گروهی خواهند بود که این قابلیت را دریافت میکنند.

شناسایی محتوای CSAM

بخش دوم و مهم تر اقدام جدید اپل، طی کردن گامهای جدید برای مبارزه با “محتوای سوء استفاده جنسی از کودکان” یا به اختصار CSAM است. اپل توضیح داده که CSAM شامل محتوایی است که اقدامات جنسی را نشان میدهد که کودکان در آن دخیل هستند.

این قابلیت که امروز بخشی از آن لو رفت به اپل امکان میدهد که در صورت ذخیره تصاویر CSAM در آیکلود آنها را شناسایی کند. سپس اپل این موضوع را به “مرکز ملی رسیدگی به گم شدن و سوء استفاده از کودکان” گزارش میدهد که گزارشهای CSAM را دریافت کرده و از طریق همکاری نزدیک با مقامات قانونی به آنها رسیدگی میکند.

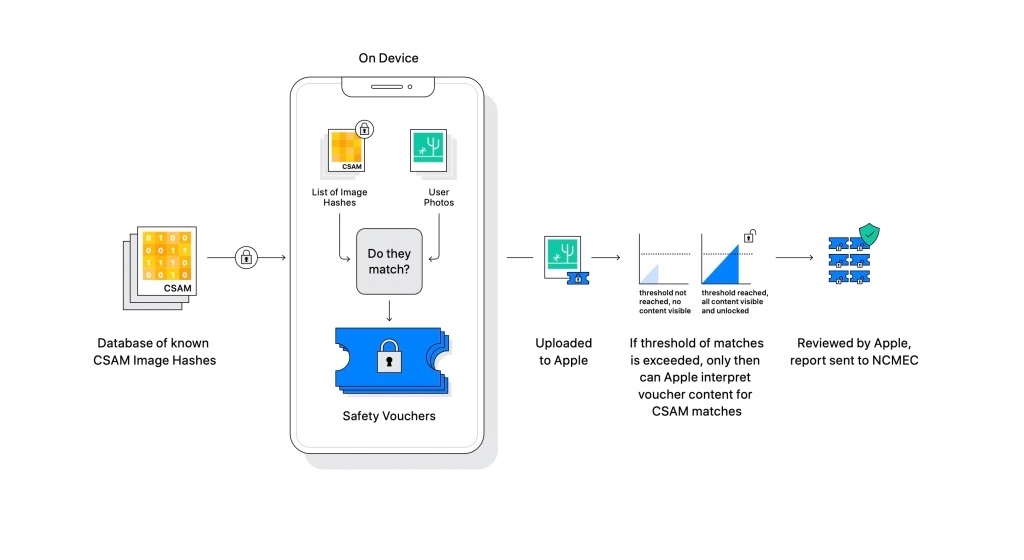

اپل دائماً تأیید کرده که این قابلیت تشخیص CSAM با در نظر گرفتن حریم خصوصی کاربران طراحی شده است. به عبارتی این شرکت تصاویر موجود روی دستگاه شما را بررسی میکند تا با دیتابیس تصاویر CSAM ارائه شده توسط این مرکز تطبیق دهد. همه این فرایندها روی دستگاه انجام شده و اپل دیتابیس ذکر شده را در قالب یک مجموعه هش ناخوانا منتقل میکند که به صورت امن روی دستگاههای کاربران ذخیره میشوند.

طبق توضیحات اپل:

پیش از ذخیره یک عکس در آیکلود، یک فرایند تطبیق دهی روی دستگاه انجام میشود تا عکس را با یک مجموعه ناخوانا از هشهای CSAM تطبیق دهد. این فرایند تطبیق دهی با استفاده از فناوری رمزنگاری انجام شده و به آن تطابق مجموعههای خصوصی گفته میشود که بدون افشا کردن نتیجه، مشخص میکند آیا تطبیقی وجود داشته یا خیر. تطبیق دهی مجموعههای خصوصی (PSI) به اپل امکان میدهد که تطبیق داشتن هش یک تصویر با هش عکسهای شناخته شده در زمینه CSAM را تشخیص دهد بدون اینکه درباره هش عکسهای غیرمنطبق اطلاعاتی افشا شود. همچنین PSI طوری پیاده سازی شده که در صورت وجود تطبیق کاربر از آن باخبر نمیشود.

اگر تطبیقی روی دستگاه وجود داشته باشد، یک سند امنیتی تهیه میشود که نتیجه در آن کدگذاری شده است. سپس فناوری به اسم به اشتراک گذاری مخفیانه حد آستانه مورد استفاده قرار میگیرد که اطمینان میدهد اپل امکان بررسی و تفسیر این سند امنیتی را ندارد مگر اینکه عکسهای آیکلود از یک حد آستانه خاص که نشان دهنده CSAM بودن محتواست، عبور کنند.

به گفته اپل “مثلاً اگر یک داکیومنت مخفی به هزار بخش تقسیم شود و حد آستانه 10 باشد، در این صورت میتوان با استفاده از هر یک از این 10 سهم، دوباره به آن داکیومنت مخفی رسید اما اگر تنها 9 سهم در اختیار داشته باشیم، هیچ اطلاعاتی درباره این داکیومنت مخفی افشا نخواهد شد.”

اپل حد آستانه مورد استفاده خودش – یعنی تعداد تطبیقهای یک محتوا با CSAM برای فراهم شدن امکان تفسیر سندهای امنیتی – را مشخص نمیکند. اما وقتی تعداد تطبیقها به این حد آستانه برسد، اپل به صورت دستی گزارش را بررسی میکند تا از تطبیق مطمئن شود و بعد محتوا را غیرفعال کرده و یک گزارش برای مرکز رسیدگی به پروندههای گم شدن و سوء استفاده از کودکان میفرستد.

این آستانه از این جهت مهم است که مانع از نشان گذاری غلط حسابهای کاربری میشود. بررسی هم دستی هم یک گام دیگر اضافه میکند تا احتمال خطا به حداقل برسد و کاربران میتوانند برای برگرداندن حساب کاربری خودشان یک درخواست ثبت کنند. به گفته اپل این سیستم نرخ خطای کمتر از 1 در 1 تریلیون در سال دارد. گرچه همه چیز روی دستگاه انجام میشود اما اپل تنها عکسهایی را تحلیل میکند که روی آیکلود ذخیره شده باشند. عکسهایی که کاملاً روی دستگاه خود کاربر ذخیره شده باشند در این فرایند مشارکت داده نمیشوند.

به گفته اپل این سیستم نسبت به اسکن تحت کلود مهم تر و ایمن تر است چون تنها کاربرانی را گزارش میدهد که محتوای CSAM دارند و نیازی به اسکن پیوسته همه عکسها در کلود وجود ندارد.

قرار است این قابلیت اول برای آمریکا عرضه شود اما اپل امیدوار است که بتواند آن را برای سایر مناطق جهان نیز عرضه کند.

Siri و جستجو

در نهایت، قرار است در Siri و Search هم تغییراتی ایجاد شود:

اپل قصد دارد با تأمین منابع بیشتر برای کمک به امنیت کودکان و والدین در فضای مجازی، راهنماهایی در Siri و Search پیاده سازی کند. مثلاً کاربرانی که از Siri بپرسند چطور میتوانند محتوای CSAM یا سوء استفاده از کاربران را گزارش دهند به سمت منابع مفید هدایت میشوند.

همچنین این بخش از اکوسیستم اپل آپدیت میشود تا در صورتی که کاربر جستجوهایی مرتبط با CSAM انجام دهد، وارد عمل شده و مداخله کند. این مداخلات به کاربران توضیح میدهند که دیدن چنین محتوایی زیانبار و مشکل آفرین است و محتوای مفید برای مقابله با این مشکل را در اختیار آنها قرار میدهد.

قرار است امسال با عرضه iOS 15، iPadOS 15، watchOS 8 و macOS Monterey شاهد آپدیت بخش Siri و جستجو در اکوسیستم اپل باشیم.

نظر کارشناسان

John Clark مدیرعامل و رئیس مرکز گزارش سوء استفاده و مفقود شدن کودکان: توسعه مراقبتهای اپل از کودکان حرکتی انقلابی و تحول آفرین است. با توجه به تعداد بسیار زیاد کاربرانی که از محصولات اپل استفاده میکنند این راهکارهای امنیتی میتواند به نجات زندگی کودکانی که در فضای آنلاین فریب خورده و تصاویر وحشتناکشان در اینترنت منتشر میشود، کمک کند. ما معتقدیم که تنها با انجام حرکات جدی میتوان با این مشکل مقابله کرد. به لطف حرکات شرکتهایی مثل اپل حتماً میتوانیم به این هدف برسیم. ما از اپل قدردانی میکنیم و به دنبال همکاری بیشتر در راستای ایمن سازی جهان برای کودکان خواهیم بود.

Julie Cordua مدیرعامل شرکت Thorn: ما در Thorn به حق داشتن حریم خصوصی در فضای آنلاین معتقدیم از جمله برای کودکانی که تصاویر سوء استفاده جنسی از آنها ضبط شده و بدون رضایتشان در اینترنت توزیع میشود. تعهد اپل برای پیاده سازی راهکارهای تکنولوژیکی که به مراقبت از حریم خصوصی و امنیت کاربران کمک میکند ما را یک مرحله به جهانی که در آن محتوای هر پلتفرم دیجیتال با سیستم تشخیص CSAM بررسی میشود نزدیک تر میکند؛ به جهانی که در آن هر کودک فرصت کودک بودن را دارد.

Stephen Balkam، مدیر و بنیانگذار مؤسسه امنیت آنلاین خانواده: ما از تغییرات مستمر رویکرد اپل برای مراقبت از امنیت آنلاین کودکان حمایت میکنیم. با توجه به چالشهای پیش روی والدین برای حفاظت از کودکان خودشان در فضای آنلاین بسیار مهم است که شرکتهای تکنولوژیکی دائماً ابزارهای امنیتی خودشان را به روزرسانی کنند تا به خطرات ایجاد شده برای کودکان واکنش نشان دهند.

Eric Holder دادستان کل سابق آمریکا: افزایش وحشتناک حجم محتوای سوء استفاده جنسی از کودکان چالشی است که باید با ابتکار از سوی اهالی فناوری رفع شود. تلاشهای جدید شرکت اپل برای شناسایی محتوای CSAM گام مهمی است که نشان میدهد نیاز نیست مراقبت از امنیت کودکان با هزینه تجاوز به حریم خصوصی انجام شود و نشانی دیگر از جدیت همیشگی شرکت اپل برای تبدیل کردن جهان به جایی بهتر برای زندگی و محافظت پیوسته از حریم خصوصی مشتریان این شرکت است.

George Terwilliger دستیار پیشین دادستان کل ایالات متحده: اعلامیه اپل گام بسیار مهم و مثبتی برای توانمندسازی والدین و نهادهای قانونی جهت مقابله با آسیب رسیدن به کودکان با محتوای CSAM است. با توجه به گسترش تلاشهای شرکت اپل برای تشخیص و گزارش CSAM، حالا مقامات قانونی بهتر میتوانند تهدیدکنندگان کودکان را شناسایی و متوقف کنند.

Benny Pinkas استاد دانشکده علوم کامپیوتر در دانشگاه Bar Ilan: سیستم PSI شرکت اپل توازن بسیار خوبی بین حریم خصوصی و کاربرد برقرار کرده و به شناسایی محتوای CSAM کمک زیادی میکند؛ در عین حال حریم خصوصی کاربران را حفظ کرده و تشخیصهای مثبت کاذب را به حداقل میرساند.

Mihir Bellare، استاد علوم کامپیوتر و مهندسی دانشگاه سن دیگو: مقابله با محتوای CSAM گام مهمی است اما پیاده سازی آن نیاز به دقت دارد. انجام این کار به صورت ساده مستلزم اسکن همه عکسهای آیکلود کاربران است اما ممکن است این تصاویر شامل لحظات خصوصی زندگی ما باشد. کاربران خواهان مخفی ماندن این تصاویر در برابر دسترسیهای اپل هستند. به همین ترتیب هرگز نباید دیتابیس عکسهای CSAM منتشر شود یا در دسترس کاربران قرار بگیرد. اپل راهی برای تشخیص و گزارش دادن متخلفان CSAM همزمان با حفظ حریم خصوصی کاربران پیدا کرده است.

David Forsyth رئیس علوم کامپیوتر در دانشگاه ایلینوی: رویکرد اپل نسبت به روشهایی که من به شخصه از آنها اطلاع دارم قابلیت بیشتری برای حفاظت از خصوصی کاربران دارد. به نظر من این سیستم میتواند احتمال پیدا شدن کاربرانی که محتوای CSAM دارند یا مبادله میکنند را افزایش دهد. انتظار میرود که برای کاربران معمولی نفوذ به حریم خصوصی حداقل یا صفر باشد چون تنها در صورتی که تعداد تطبیقهای یک عکس با تصاویر CSAM کافی باشد و با تصاویر CSAM شناخته شده انطباق داشته باشند، اپل امکان مشاهده محتوای آن را خواهد داشت. دقت این سیستم تطبیق دهی به همراه آستانههای تعریف شده باعث شده که احتمال نمایش محتوای تصاویری که مربوط به CSAM نیستند برای کاربران بسیار کم باشد.