آیا هوش مصنوعی توانایی تشخیص ویدئوهای دستکاری شده را دارد؟ در ادامه با روکیدا همراه شوید.

ویرایشگران ویدئو توانستند کلمات و حرفهای یک سخنران را اصلاح کنند. یعنی جملههایی را به سخنرانی او اضافه کنند یا از سخنرانی حذف کنند. به شکلی این کار را انجام دادند که قابل تشخیص نباشد.

شما برای تشخیص ویدئوهای دیپفیک نیاز به افراد متخصص دارید. البته ممکن است افراد متخصص و سیستمهای کامپیوتری هم متوجه این تغییرات نشوند.

این کار یک سال پیش با همکاری منیش آگراوالا از دانشگاه استنفورد انجام شد. کار آنها نتیجه توسعه فناوری همگام سازی لب بوده است. این ابزار میتواند کلماتی که هرگز آن شخص استفاده نکرده را به ویدئو وارد کند.

این ابزار برای رفع ایرادات یک فیلم ساخته شد. سازندگان بدون تکرار فیلم برداری میتوانستند ایرادات را برطرف کنند.

آیا فیلم یا سریال در کشورهای مختلفی پخش میشود؟ با این ابزار حرکات لب بازیگران با زبان جدید همگام میشود.

از این فناوری میتوان برای ساخت فیلمهای دیپفیک استفاده کرد. فیلمهای دیپ فیک برای تغییر در واقعیت ایجاد میشوند. آنها واقعیت را به شکل دیگری به شما نشان میدهند.

برای مثال: حزب جمهوری خواه از این تکنولوژی استفاده میکند. آنها مصاحبه با معاون رییس جمهوری یعنی جو بایدن را تغییر میدهند.

شما امروز این مقاله را در روکیدا میخوانید. او در حال حاضر رییس جمهور منتخب ایالات متحده است.

تابستان امسال آگروالا و همکاران او از یک راه و روش جدید برای شناسایی فیلمهای جعل شده رونمایی کردند. این کار در دانشگاه استنفورد و یوسی برکلی انجام شد.

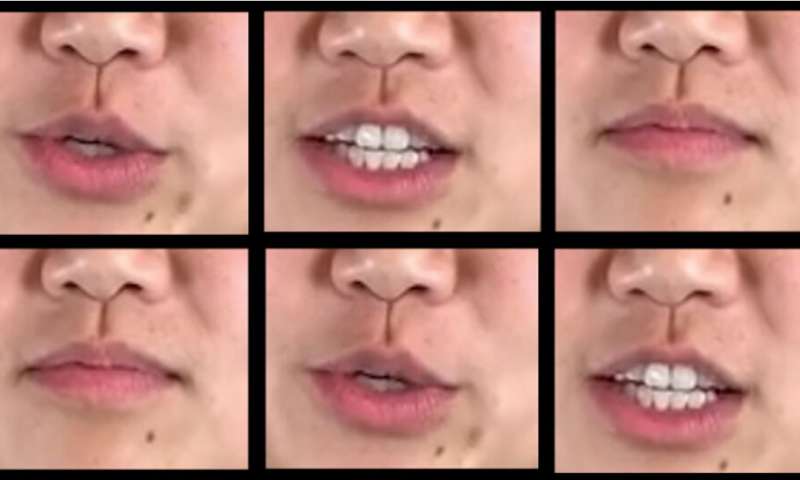

برنامه جدید با تشخیص همسان نبودن صدای سخنران و حالت دهان آنها کار میکند. این راه و روش جدید در ۸۰ درصد مواقع ویدئوهای جعلی را تشخیص میدهد.

اگراوالا هشدار داد که هیچ راه حل فنی و طولانی مدت برای پیدا کردن فیلمهای دیپفیک وجود ندارد.

او مدیر انستیتوی براون در استنفورد و استاد علوم رایانهای است. آنها در جهت نوآوری و رسانه کار میکنند. بخش آنها وابسته به موسسه هوش مصنوعی انسان محور استنفورد است.

او گفت: ما باید سطح سواد رسانهای مردم را افزایش دهیم. با افزایش سواد رسانهای، مردم اطلاعات غلط را تشخیص میدهند. این روش برای جلوگیری انتشار چنین ویدئوهایی مناسب است.

هر چقدر که فناوریها در تولید ویدئوهای دیپ فیک پیشرفت کند، توانایی فناوری برای شناسایی این ویدئوها کمتر و کمتر میشود. ما باید بر روی روشهای غیر فنی کار کنیم.

اما فیلم دستکاری شده از جو بایدن با این تکنولوژی تشخیص داده نشد. این فیلم تقلبی توسط مصاحبه کننده با جو بایدن تشخیص داده شد. او گفت که سوالات در این فیلم تغییر داده شده است.

تکنولوژی دیپفیک چطور کار میکند؟

دلایل زیادی برای دستکاری فیلم وجود دارد. آیا شما یک نمایش تلویزیونی یا ویدئو تبلیغاتی میسازید؟ این تکنولوژی اصلاح اشتباهات شما را ارزان و آسان میکند. با این فناوری به راحتی میتوانید متن را تغییر دهید.

این تکنولوژی بسیار مفید است، پس مشکل از کجا شروع میشود؟ برخی از افراد برای انتشار اطلاعات نادرست از این ابزار استفاده میکنند.

باید بدانید که بسیاری از تکنیکهای این تکنولوژی قابل تشخیص نیستند. یعنی بدون این که متوجه شوید اطلاعات اشتباه دریافت میکنید.

بسیاری از ویدئوهای دیپفیک بر پایه تغییر حالت چهره کار میکنند. یعنی به شکل فوق العادهای صورت شخص را تغییر میدهند، انگار که شخص دیگری است!

اما تا زمانی که ابزار همگام سازی لب بتواند کاملا بی عیب باشد راه زیادی مانده است. این ابزارها معمولا در تغییر یک ویدئو از خود ردپا به جا میگذارند. این ردپا میتواند دیجیتالی یا قابل تشخیص با چشم باشد. کامپیوترها میتوانند آنها را تشخیص دهند.

در طرف دیگر، فناوریهای همگام سازی لب در حال پیشرفت هستند. آنها با دقت بیشتری کار میکنند و تشخیص آن سختتر میشود. فناوریهای جدید قسمت کوچکتری از تصویر را تغییر میدهند. آنها حرکات لب را به شکلی ایجاد میکنند که با حرکت دهان فرد یکسان باشد.

حرکات دهان شخص را دقیقا به شکل کلمه تغییر میدهند. آگراوالا میگوید: اگر نمونههای کافی از تصویر و صدای یک نفر در دسترس باشد. تولید کننده ویدئوهای دیپفیک میتواند از زبان او هر موردی را بگوید. حرفهایی که واقعا نگفته اما فیلم آنها وجود دارد.

آیا میتوانیم تقلب در ویدئو را پیدا کنیم؟

اگراوالا نگران استفاده غیر اخلاقی از این فناوریها است. او در مورد این نگرانی با اوهد فرید همکاری کرد. آنها در این همکاری یک ابزار شناسایی ساختهاند.

اوهد فرید دانشجوی فوق دکتری در دانشگاه استنفورد است. هانی فرید استاد دانشکده اطاعات یوسی برکلی است.

ایده اصلی بر اساس ناسازگاریها بود. آنها به دنبال نا سازگاری بین تلفظ یک حرف یا حالت دهان و صدای آن حرف بودند.

محققان به دهان فرد نگاه میکنند. برای به زبان آوردن حرف B، M یا P باید لبهای خود را محکم فشار دهید. آیا دیپفیک میتواند این کار را انجام دهد؟

محققان در ابتدا یک تکنیک دستی را امتحان کردند. آنها از نظارت انسانی برای پیدا کردن نا سازگاریها استفاده کردند. این روش به خوبی جواب داد اما حجم کار بسیار زیادی را ایجاد کرد. این روش به زمان زیادی هم نیاز داشت.

بعد از آزمایش با نظارت انسانی آنها یک شبکه عصبی بر اساس هوش مصنوعی ساختند. این روش جدید بسیار سریعتر بود.

تحلیل این تکنولوژی از ویدئوی باراک اوباما با نظارت انسانی یکی بود. شبکه عصبی بیشتر از ۹۰ درصد همگام سازی لب را در این ویدئو تشخیص داد.

البته دقت این شبکه عصبی در تشخیص سخنرانیهای دیگر حدود ۸۱ درصد بود.

آزمایش حقیقت

محققان این آزمایش میگویند که کار آنها بازی “موش و گربه” است. هرچقدر که تکنیکهای دیپفیک پیشرفت میکند سرنخهای کمتری را پشت سر میگذارد.

آگروالا میگوید: در مدت زمان طولانی چالش ما مبارزه با فیلمهای دیپفیک نیست. ما باید با اطلاعات نادرست مبارزه کنیم.

بیشتر اطلاعات نا درست از تغییر معنای موردی است که سخنران گفته است. عدهای معنی حرفها را تغییر میدهند.

باید بدانید که تشخیص دستکاری شدن یک ویدئو با تشخیص اطلاعات غلط یا گمراه کننده در ویدئو متفاوت است. ممکن است عدهای در یک ویدئو مردم را گمراه کنند. تشخیص این مسئله بسیار سختتر است.

در نتیجه برای کاهش اطلاعات غلط باید سواد رسانهای مردم را افزایش دهیم. در طرف دیگر حکومتها باید توسعه پیدا کنند. یعنی قوانینی را علیه تولید عمدی اطلاعات نادرست تصویب کنند.

این قوانین باید شامل جریمههایی بر علیه تولید کنندگان اطلاعات نادرست باشد. همچنین راه و روشهایی برای ترمیم آسیبهای این اطلاعات نادرست باید ایجاد شود.

منبع: techxplore.com